最近,一家名叫DeepSeek的初创公司经过技术迭代与升级,发布了全新一代大模型,“DeepSeek-V3”。由于这款大模型太过好用,DeepSeek R1 更是直接免费开源,在AI发烧友圈子传播后,传到了海外社交平台、技术论坛,引发了海外网友的连连称赞。

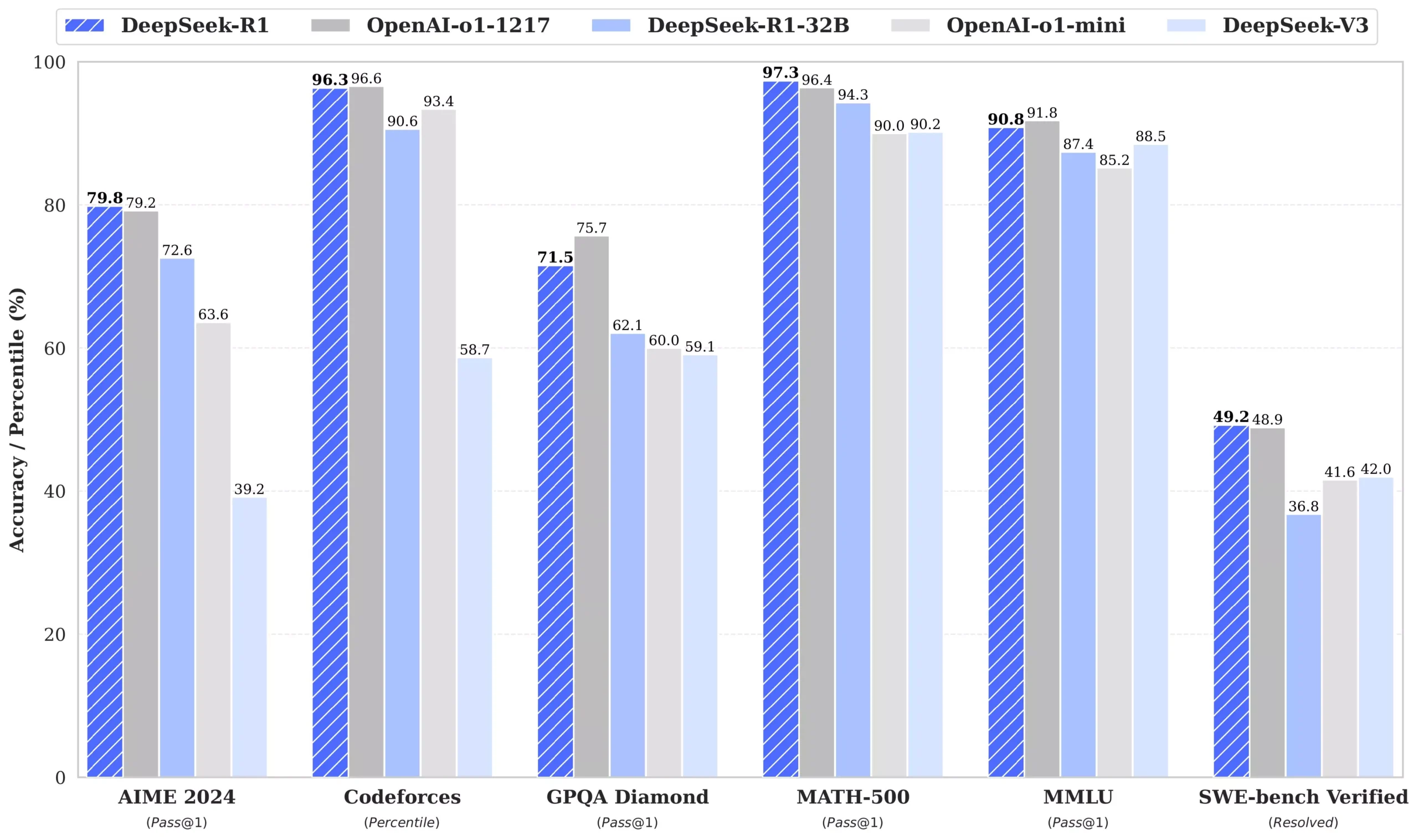

各项性能指标更是和OpenAI-o1 模型不相上下,甚至做到了小部分的超越,关键是开源的,我们可以本地部署使用

1、本地部署,我们可以通过Ollama来进行安装

Ollama 官方版:【点击下载】

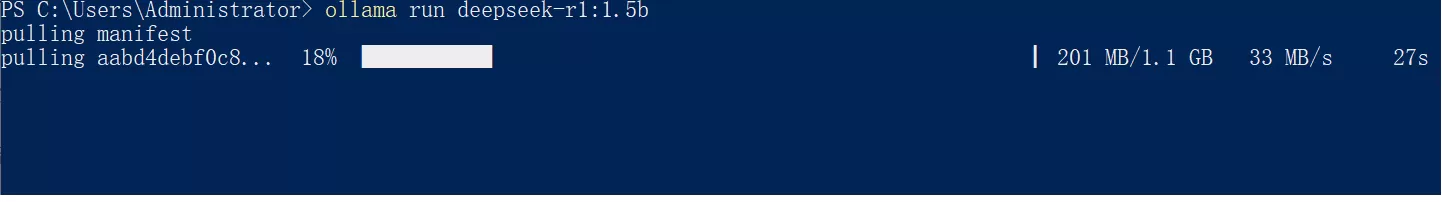

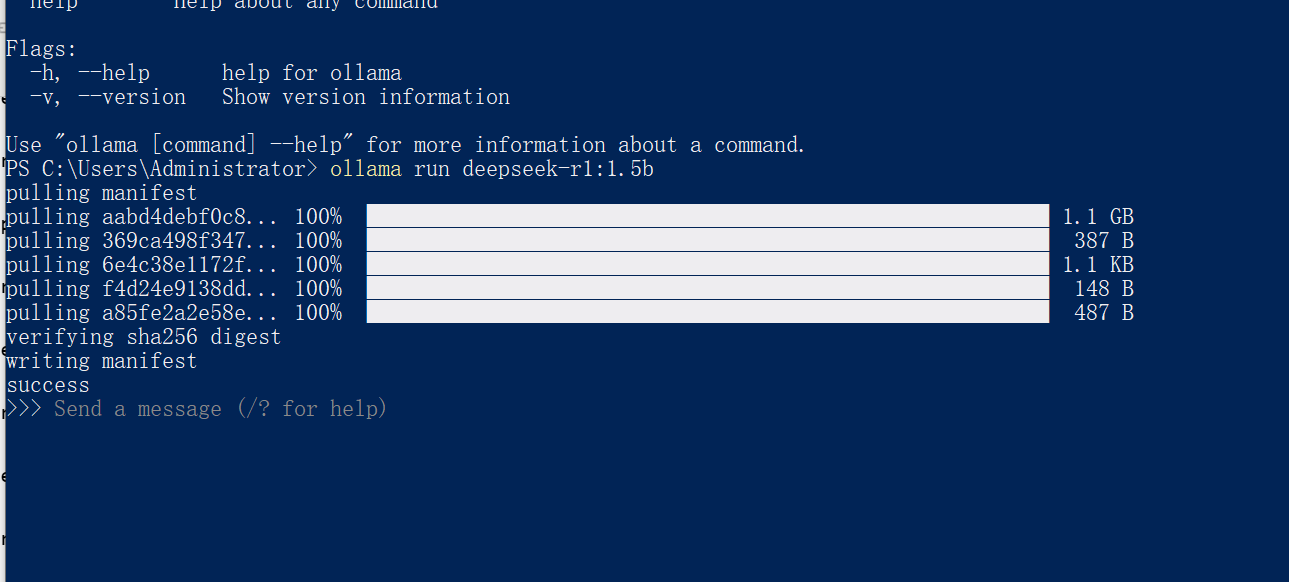

安装完成后打开Powershell,然后根据显存大小输入以下命令,安装 DeepSeek

安装命令

1.5B Qwen DeepSeek R1【适合4G显存以下】

ollama run deepseek-r1:1.5b

7B Qwen DeepSeek R1【适合6G显存以下】

ollama run deepseek-r1:7b

8B Llama DeepSeek R1【适合10G显存以下】

ollama run deepseek-r1:8b

14B Qwen DeepSeek R1【适合12G显存左右】

ollama run deepseek-r1:14b

32B Qwen DeepSeek R1【适合24G显存左右】

ollama run deepseek-r1:32b

70B Llama DeepSeek R1【最高显存】

ollama run deepseek-r1:70b

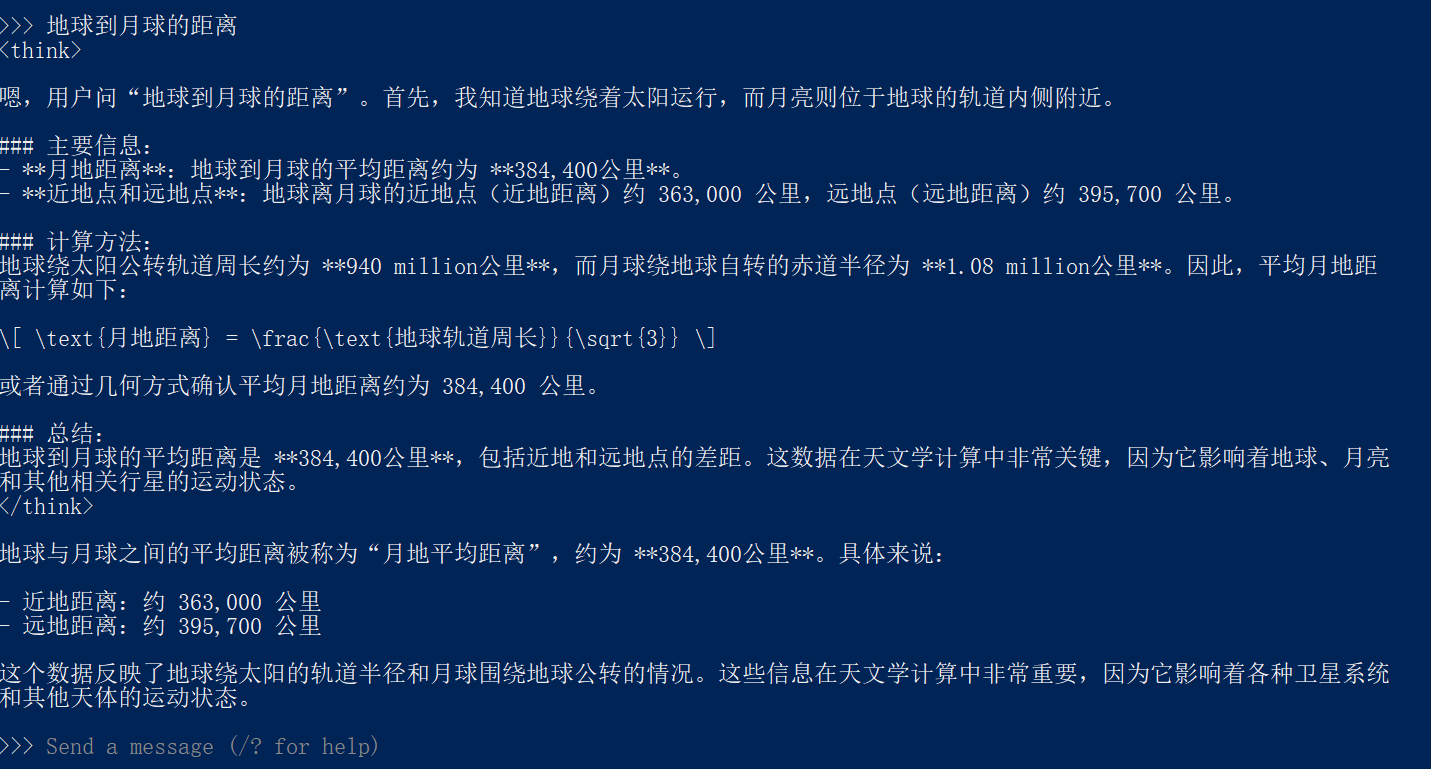

安装后即可在命令行中直接发消息使用

2、进阶

以上方法虽然可实现DeepSeek了,但它还是Run在命令行下

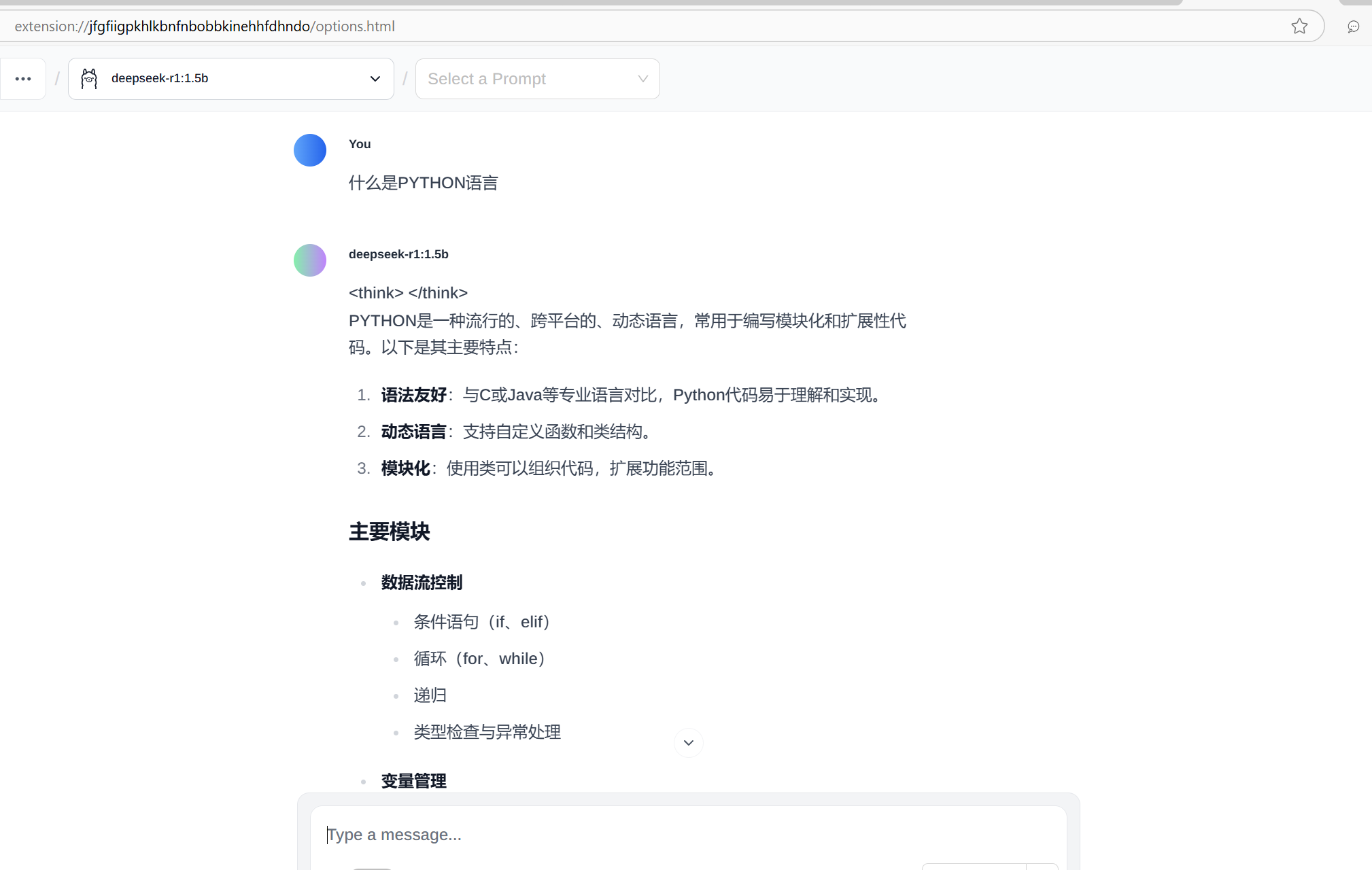

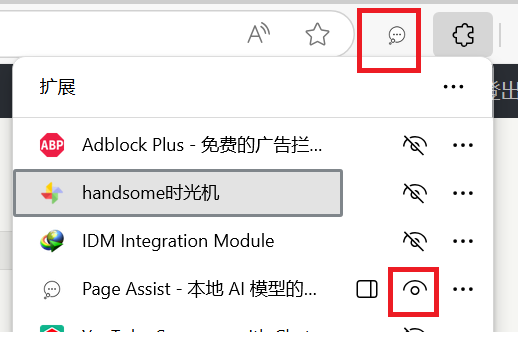

我们可以为浏览器安装Page Assist这个扩展,实现在浏览器上使用本地模型的功能

安装扩展,然后启用,将其固定到工具栏上(可不操作)

然后点击这个扩展,即可享用~